0. Warum stellen große Unternehmen derzeit Datenanalysten ein?

Große Unternehmen stellen Datenanalysten ein, um fundierte Geschäftsentscheidungen auf der Grundlage von Informationen zu treffen, die analysiert werden müssen.

Datenanalysten verwenden verschiedene Tools und Technologien, um diese Daten zu analysieren und Einblicke zu liefern, die Unternehmen dabei helfen, ihre Betriebsabläufe zu verbessern, ihren Umsatz zu steigern und ihre Wettbewerbsfähigkeit auf dem Markt zu erhalten.

Durch die Verbreitung von Big Data ist die Nachfrage nach Datenanalysten in den letzten Jahren stark gestiegen und wird voraussichtlich weiter steigen.

1. Was muss man studieren, um ein Datenanalyst zu werden?

Um ein Datenanalyst zu werden, sollte man eine Kombination aus Informatik, Statistik und Geschäft studieren.

Es ist erforderlich, eine solide Grundlage in Computerprogrammiersprachen wie Python und SQL sowie Erfahrung in statistischer Analyse-Software wie R oder SAS zu haben. Darüber hinaus sollte man ein gutes Verständnis von Geschäftsprinzipien haben und die Fähigkeit besitzen, effektiv mit nicht-technischen Interessengruppen zu kommunizieren.

Darüber hinaus ist es wichtig, fortlaufend Fähigkeiten in maschinellem Lernen und Datenvisualisierung zu verbessern, um wettbewerbsfähig auf dem Arbeitsmarkt zu sein.

2. Welche Arten von Unternehmens- und Webdaten analysiert ein Datenanalyst hauptsächlich?

Datenanalysten unterstützen Organisationen in der Regel dabei, fundierte Entscheidungen zu treffen, indem sie interne Unternehmensdaten und Webdaten verwenden.

Dies kann die Sammlung, Bereinigung und Organisation großer Datensätze sowie die Identifizierung von Trends und Mustern mithilfe statistischer und analytischer Methoden umfassen.

Datenanalysten verwenden auch Tools wie Tabellenkalkulationen und Datenbanken, um Daten zu speichern, zu manipulieren und Berichte sowie Visualisierungen zu erstellen, um die Ergebnisse anderen innerhalb der Organisation zu präsentieren.

Das Ziel eines Datenanalysten ist es, Organisationen dabei zu unterstützen, ihre Betriebsabläufe zu verbessern und ihre Ziele mithilfe von Daten zu erreichen.

3. Welche Fähigkeiten muss man als Datenanalyst erlernen, um externe Daten zu sammeln?

Als Datenanalyst sollte man verschiedene Fähigkeiten erlernen, um externe Daten zu sammeln. Zu den wichtigsten Fähigkeiten gehören Web-Scraping, API-Integration und SQL.

Web-Scraping bezieht sich auf das Extrahieren von Daten von Websites mithilfe spezieller Software. Dies kann nützlich sein, um Daten von Websites zu sammeln, die keine anderen Mittel zum direkten Zugriff auf API oder Daten bieten.

API-Integration beinhaltet die Verwendung von Application Programming Interfaces (APIs) zum Zugriff auf Daten von Websites oder anderen Online-Services. Viele Websites und Dienste bieten APIs an, die es Entwicklern ermöglichen, systematisch und programmgesteuert auf Daten zuzugreifen.

SQL (Structured Query Language) ist eine Programmiersprache, die zur Verwaltung und Manipulation von in Datenbanken gespeicherten Daten verwendet wird. Um auf Datenbankdaten zuzugreifen und sie zu analysieren, sollte man SQL beherrschen.

Neben diesen technischen Fähigkeiten sind auch starke Problemlösungs- und Kommunikationsfähigkeiten erforderlich, um externe Daten effektiv zu sammeln und zu interpretieren.

4. Wie hoch ist das Gehalt eines Datenanalysten mit herausragenden Fähigkeiten im Daten sammeln?

Das genaue Gehalt eines Datenanalysten mit herausragenden Fähigkeiten im Daten sammeln hängt von verschiedenen Faktoren wie spezifischer Position, Branche, Standort, Erfahrungsniveau, spezifischen Fähigkeiten usw. ab, daher ist es schwierig, ein genaues Gehalt festzulegen.

Laut Daten des Bureau of Labor Statistics betrug das durchschnittliche Jahresgehalt im Bereich der Datenanalyse, einschließlich Datenanalysten, im Mai 2019 84.810 US-Dollar. Diese Zahl spiegelt möglicherweise nicht die Gehälter der Top-Datenanalysten wider. Im Allgemeinen können Datenanalysten mit herausragenden Fähigkeiten im Daten sammeln und einer erfolgreichen Erfolgsbilanz in ihrem Bereich ein höheres Gehalt erhalten als Personen mit allgemeineren Fähigkeiten und Erfahrungen.

Es ist festzustellen, dass Datenanalysten oder Data Scientists in ähnlichen Positionen relativ hohe Gehälter erhalten.

5. Was ist der schwierigste Teil beim Web-Scraping?

Als Datenanalyst sollte man zunächst über die Fähigkeit verfügen, Daten zu sammeln.

Einer der schwierigsten Teile beim Web-Scraping ist der Umgang mit sich ständig ändernden Strukturen von Webseiten. Websites werden häufig aktualisiert und neu gestaltet, was zu Änderungen in der Seitenstruktur führen kann. Da Web-Scraping-Skripte so konzipiert sind, dass sie Daten aus bestimmten Elementen einer Webseite extrahieren, können sie durch diese Änderungen beschädigt werden. Daher müssen Web-Scraping-Skripte regelmäßig aktualisiert und gewartet werden, um ordnungsgemäß zu funktionieren.

Ein weiteres Problem beim Web-Scraping besteht darin, mit Websites umzugehen, die versuchen, das Scraping zu verhindern. Einige Websites verwenden Technologien wie Sicherheitscodes und Geschwindigkeitsbegrenzungen, um Scraping zu verhindern. Dies kann es schwierig machen, Daten von solchen Websites zu sammeln, und erfordert möglicherweise den Einsatz fortgeschrittener Web-Scraping-Techniken wie Proxies und Headless-Browser.

Insgesamt kann Web-Scraping eine anspruchsvolle und zeitaufwändige Aufgabe sein, aber es ist eine wichtige Fähigkeit, die Datenanalysten benötigen, um Daten aus verschiedenen Quellen zu sammeln, und eine wesentliche Fähigkeit, die sie beherrschen sollten.

6. Methoden zum Scrapen großer Datenmengen aus dem Web

Um eine große Menge an Daten effizient aus dem Web zu scrapen, sollten verschiedene Technologien kombiniert werden, um den Scraping-Prozess effizient und skalierbar zu gestalten. Einige wichtige Überlegungen bei der Scraping großer Datenmengen sind:

Verwendung einer verteilten Scraping-Architektur: Anstatt einen einzelnen Scraper auf einem einzelnen System auszuführen, sollte eine verteilte Architektur verwendet werden, um mehrere Scraper parallel auf mehreren Systemen auszuführen. Auf diese Weise kann der Scraping-Aufwand skaliert und Daten schneller gesammelt werden.

Verwendung von Caching und Queuing: Bei der Scraping großer Datenmengen kann es nützlich sein, Daten mit Caching und Queuing zu speichern und zu verwalten. Durch die Verwendung von Caching können Daten vorübergehend gespeichert werden, um zu verhindern, dass dieselben Daten mehrmals gescraped werden müssen, und durch die Verwendung von Queuing können Scraping-Seiten und Zeitpläne priorisiert werden, um den Scraping-Prozess effizienter zu verwalten.

Verwendung eines Headless-Browsers: Ein Headless-Browser ist ein Webbrowser, der ohne Benutzeroberfläche ausgeführt wird. Da ein Headless-Browser JavaScript ausführen und Seiten rendern kann, kann er nützlich sein, um Websites zu scrapen, die JavaScript verwenden, um Inhalte zu rendern. Dies erleichtert das Scrapen von Websites mit komplexen JavaScript-basierten Strukturen.

Verwendung von Proxies: Durch die Verwendung von Proxies können Web-Scraping-Verkehr über mehrere IP-Adressen geroutet werden, um zu verhindern, dass der Scraping-Verkehr von Websites, die Scraping verhindern möchten, erkannt und blockiert wird. Dies kann besonders nützlich sein, um Daten von Websites mit strengen Scraping-Richtlinien zu scrapen.

7. Web-Scraping-Spezialunternehmen Hashcraper

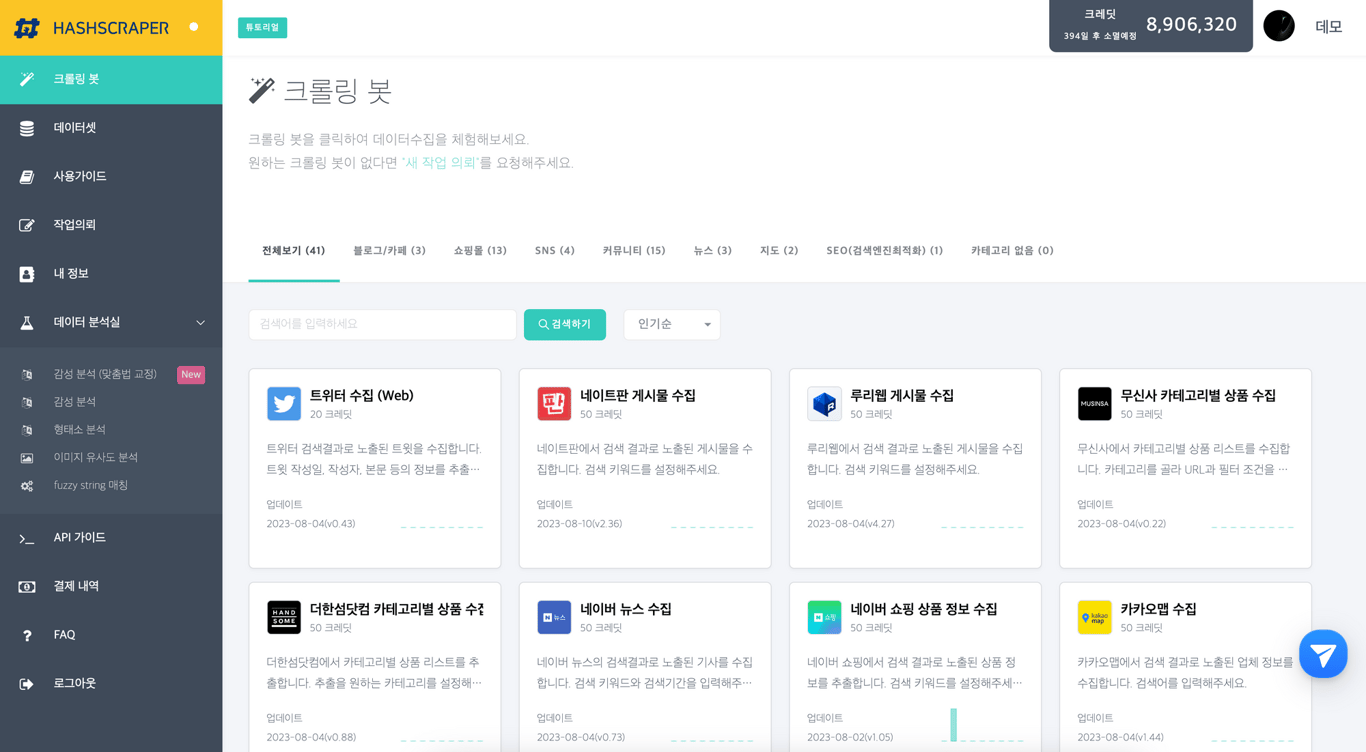

Hashcraper Data Collection Dashboard (Ermöglicht die Datensammlung von sozialen Netzwerken, Communities, E-Commerce-Websites usw.)

Hashcraper ist ein Unternehmen, das sich auf Web-Scraping spezialisiert hat und über alle erforderlichen Technologien verfügt, um große Datenmengen aus dem Internet zu sammeln.

Hashcraper verfügt über ein Team erfahrener Datenanalysten und Entwickler, die fortschrittliche Algorithmen und raffinierte Software einsetzen, um das Web zu scrapen und Daten in großem Umfang zu sammeln. Dadurch können sie große Datenmengen schnell und effizient sammeln, ohne jede Website manuell besuchen zu müssen.

Die Web-Scraping-Technologie des Unternehmens kann auch die größten und komplexesten Datensätze verarbeiten. Sie können Daten von Websites mit komplexen Layouts und Strukturen sowie von Websites, die Scraping durch Authentifizierung oder Captchas verhindern, extrahieren.

Neben Web-Scraping bietet Hashcraper eine Vielzahl anderer Dienstleistungen an, die Unternehmen dabei helfen, Daten zu verstehen. Dazu gehören Datenbereinigung und -vorverarbeitung, Datenvisualisierung und statistische Analysen. Das Expertenteam des Unternehmens kann Organisationen dabei unterstützen, Trends und Muster in den Daten zu identifizieren und diese Informationen zu nutzen, um fundierte Entscheidungen zu treffen.

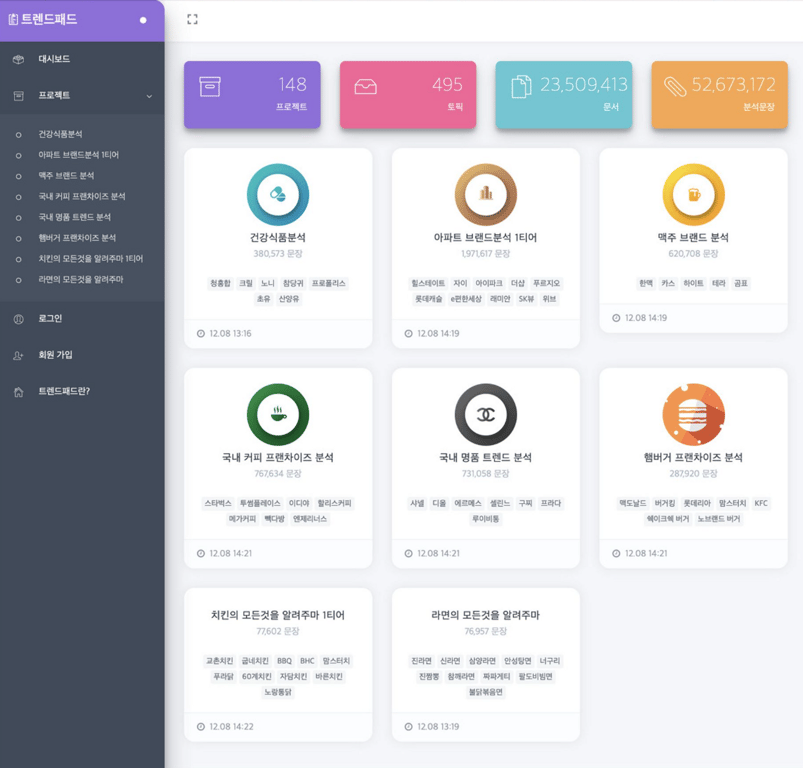

Echtzeit-Trendanalyse-Service - Trendpad

Lesen Sie auch diesen Artikel:

Automatisieren Sie jetzt die Datensammlung

Starten Sie in 5 Minuten ohne Codierung · Erfahrung mit dem Scrapen von über 5.000 Websites