0. 近期大型企业雇佣数据分析师的原因是什么?

大型企业雇佣数据分析师是因为需要分析大量数据以做出基于信息的业务决策。

数据分析师使用各种工具和技术来分析这些数据,并提供洞察力,帮助企业改善运营、增加收入,并在市场上保持竞争力。

随着大数据的普及,近几年对数据分析师的需求大幅增加,未来预计将继续增长。

1. 想成为数据分析师需要学习什么?

要成为数据分析师,需要学习计算机科学、统计学和商业的结合。

需要扎实的计算机编程语言基础,如Python和SQL,以及对统计分析软件如R或SAS的经验。此外,还需要深刻理解商业原则,并具备与非技术利益相关者有效沟通的能力。

此外,不断精进机器学习和数据可视化技能可以提高在就业市场上的竞争力。

2. 数据分析师主要分析的企业内部数据和网络数据有哪些?

数据分析师通常使用内部公司数据和网络数据来支持组织做出基于信息的决策。

这可能涉及收集、整理和组织大规模数据集,并使用统计和分析方法来识别趋势和模式。

数据分析师还可以使用工具如电子表格和数据库来存储和操作数据,并创建报告和可视化结果以向组织内其他人员传达。

数据分析师的目标是利用数据帮助组织改善运营并实现目标。

3. 作为数据分析师,要学习哪些技能才能收集外部数据?

作为数据分析师,需要学习多种技能来收集外部数据。关键技能包括网络抓取、API集成和SQL。

网络抓取是使用特殊软件从网站提取数据的过程。这对于无法通过API或其他方式直接访问数据的网站非常有用。

API集成涉及使用应用程序编程接口(API)访问网站或其他在线服务的数据。许多网站和服务提供API,使开发者可以以系统化和编程方式访问数据。

SQL(结构化查询语言)是用于管理和操作存储在数据库中的数据的编程语言。作为数据分析师,需要熟练掌握SQL以访问和分析存储在数据库中的数据。

除了这些技术能力外,还需要强大的问题解决和沟通能力,以有效地收集和解释外部数据。

4. 具有出色数据收集能力的数据分析师的年薪是多少?

具有出色数据收集能力的数据分析师的确切年薪取决于特定职位、行业、地点、经验水平、特定技能等多个因素,因此很难确定准确的年薪。

根据劳工统计局(Bureau of Labor Statistics)的数据,包括数据分析师在内的数据分析领域的平均年薪在2019年5月为84,810美元。然而,这个数字可能不反映顶级数据分析师的薪水。通常,具有出色数据收集技能和该领域强大业绩的数据分析师可能比普通技能和经验的人获得更高的薪水。

可以看到,数据分析师或数据科学家在同类工作中相对获得较高的薪水。

5. 网络爬虫(抓取)中最困难的部分是什么?

作为数据分析师,首先需要具备收集数据的能力。

在网络抓取中,最困难的部分之一是处理不断变化的网页结构。网站经常更新和重新设计,导致页面结构可能发生变化。由于网络抓取脚本是根据结构设计来从网页特定元素提取数据的,因此这可能导致网络抓取脚本失效。因此,为了确保网络抓取脚本持续正常运行,需要经常更新和维护。

另一个网络抓取的问题是处理试图阻止抓取的网站。一些网站使用技术如验证码和速度限制来防止抓取器从页面中提取数据。这可能使从这些网站收集数据变得困难,可能需要使用代理和无头浏览器等高级网络抓取技术。

总的来说,网络抓取可能是一项困难且耗时的工作,但对于数据分析师从各种来源收集数据是必备的重要技能。

6. 如何批量从网络上抓取数据

要从网络上批量抓取大量数据,需要结合多种技术以使抓取工作高效且可扩展。在抓取大量数据时,需要考虑以下几个关键要点:

使用分布式抓取架构:使用分布式架构,可以在多个系统上并行运行多个抓取器,而不是在单个系统上运行单个抓取器。这样可以扩展抓取工作并更快地收集数据。

使用缓存和队列:在抓取大量数据时,使用缓存和队列来存储和管理收集的数据可能很有用。使用缓存可以暂时存储数据,避免多次抓取相同数据,而使用队列可以优先指定要抓取的页面和时间,更有效地管理抓取过程。

使用无头浏览器:无头浏览器是一种在没有用户界面的情况下运行的网络浏览器。由于无头浏览器能够执行JavaScript并生成页面,因此可以帮助抓取使用JavaScript渲染内容的网站。这使得更容易抓取使用复杂基于JavaScript的结构的网站。

使用代理:使用代理可以通过多个IP地址路由网络抓取流量,从而避免被试图阻止抓取的网站检测和阻止。这对于在有严格抓取政策的网站上抓取大量数据可能很有用。

7. 网络抓取专业公司 Hashcraper

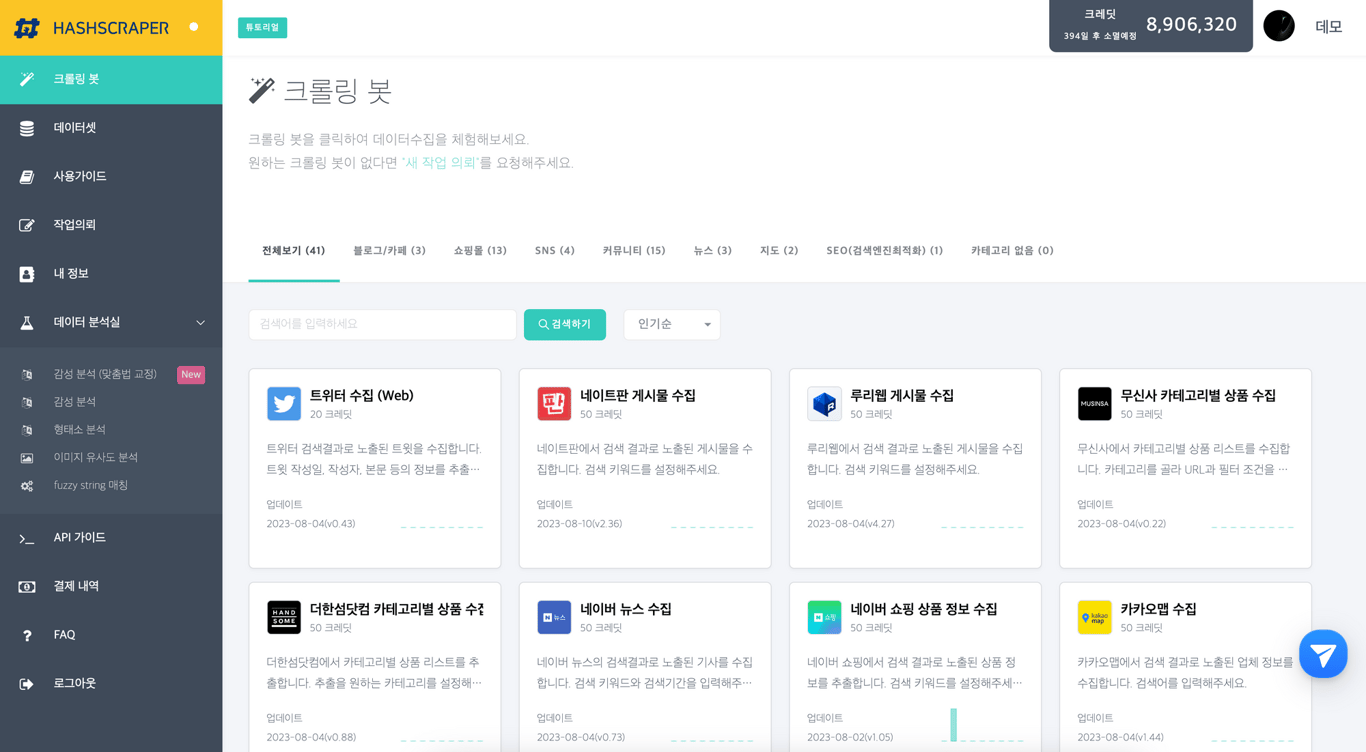

Hashcraper 数据采集仪表板(可从社交媒体、社区、电子商务等网站采集数据)

Hashcraper 是一家专门从事网络爬虫的公司,拥有获取互联网大量数据所需的所有技术。

Hashcraper 拥有经验丰富的数据分析师和开发团队,他们使用先进算法和精密软件来爬取网络并收集大规模数据。这使得可以快速高效地收集大量数据,而无需手动访问每个网站。

公司的网络爬取技术可以处理最大、最复杂的数据集。无论是布局和结构复杂的网站,还是需要身份验证或使用验证码防止爬取的网站,都可以提取数据。

除了网络爬取,Hashcraper 还提供各种其他服务,有助于公司理解数据。这些服务包括数据清理和预处理、数据可视化和统计分析。公司的专家团队可以帮助组织识别数据趋势和模式,并利用这些信息做出基于信息的决策。

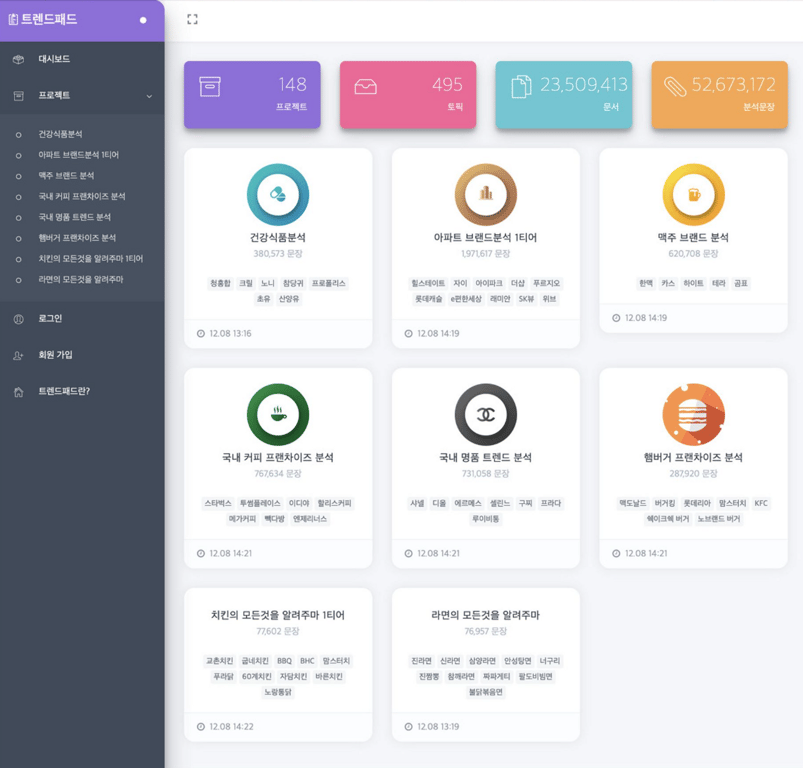

实时趋势分析服务 - 趋势板

也许您也想阅读:

数据采集,现在自动化

无需编码,5分钟即可开始 · 5000多个网站爬取经验