0. 最近、大企業がデータアナリストを雇う理由は何ですか?

大企業は情報に基づいたビジネス決定を下すために分析すべきデータが多いため、データアナリストを雇っています。

データアナリストはさまざまなツールと技術を使用してこれらのデータを分析し、企業が運営を改善し、収益を増やし、市場で競争力を維持するのに役立つ洞察を提供します。

ビッグデータの普及により、ここ数年でデータアナリストへの需要が大幅に増加しており、今後も継続して増加すると予想されています。

1. データアナリストになるためには何を勉強すればよいですか?

データアナリストになるためには、コンピュータサイエンス、統計学、ビジネスの組み合わせを学ぶ必要があります。

PythonやSQLなどのコンピュータプログラミング言語の強力な基盤と、RやSASなどの統計分析ソフトウェアの経験が必要です。また、ビジネス原則を理解し、非技術関係者と効果的にコミュニケーションできる能力が必要です。

さらに、機械学習やデータ可視化技術を継続的に磨くことで、就職市場で競争力を高めることができます。

2. データアナリストが主に分析する企業内データとウェブデータにはどのようなものがありますか?

データアナリストは通常、内部企業データおよびウェブデータを使用して、組織が情報に基づいた決定を下すのを支援します。

これには大規模なデータセットの収集、整理、構築、および統計および分析手法を使用してトレンドやパターンを識別する作業が含まれる場合があります。

データアナリストはまた、スプレッドシートやデータベースなどのツールを使用してデータを保存および操作し、レポートや可視化を作成して結果を組織内の他の人々に伝えることができます。

データアナリストの目標は、組織が運営を改善し、目標を達成するのに役立つようにデータを活用することです。

3. データアナリストとして外部データを収集するためにはどのようなスキルを学ぶ必要がありますか?

データアナリストとして外部データを収集するためには、さまざまなスキルを学ぶ必要があります。学ぶべき主要なスキルには、ウェブスクレイピング、API統合、およびSQLが含まれます。

ウェブスクレイピングは、特定のソフトウェアを使用してウェブサイトからデータを抽出することです。これはAPIや他の手段でデータに直接アクセスできないウェブサイトからデータを収集するのに役立つ場合があります。

API統合には、アプリケーションプログラミングインターフェース(API)を使用してウェブサイトや他のオンラインサービスのデータにアクセスする作業が含まれます。多くのウェブサイトやサービスは、開発者がデータに体系的かつプログラム方式でアクセスできるようにAPIを提供しています。

SQL(Structured Query Language)は、データベースに保存されたデータを管理および操作するために使用されるプログラミング言語です。データアナリストとして、データベースに保存されたデータにアクセスし、分析するためにはSQLを熟知している必要があります。

これらの技術的スキルに加えて、外部データを効果的に収集および解釈するためには、強力な問題解決能力とコミュニケーション能力が必要です。

4. データ収集能力に優れたデータアナリストの年収はいくらですか?

データ収集能力に優れたデータアナリストの正確な年収は、特定の職種、業界、地域、経験レベル、特定のスキルなど、さまざまな要因によって異なるため、正確な年収を決定することは難しいです。

労働統計局(Bureau of Labor Statistics)のデータによると、2019年5月時点でデータアナリストを含むデータ分析分野の平均年収は84,810ドルでした。ただし、この数字はトップデータアナリストの給与を反映していない可能性があります。一般的に、優れたデータ収集スキルとその分野で強力な実績を持つデータアナリストは、一般的なスキルと経験を持つ人よりも高い給与を得ることができます。

同業種の中で、データアナリストやデータサイエンティストが比較的高い給与を受け取っていることが確認されています。

5. ウェブクローリング(スクレイピング)で最も難しい部分は何ですか?

データアナリストであれば、まずデータを収集する能力が必要です。

ウェブスクレイピングで最も難しい部分の1つは、絶えず変化するウェブページの構造を扱うことです。ウェブサイトは頻繁に更新され、再設計されるため、ページの構造が変更されることがあります。ウェブスクレイピングスクリプトは、ページの特定の要素からデータを抽出するように設計されているため、これによりウェブスクレイピングスクリプトが損傷する可能性があります。その結果、ウェブスクレイピングスクリプトは正常に動作し続けるためには、定期的な更新とメンテナンスが必要です。

ウェブスクレイピングの別の問題は、スクレイピングを防ごうとするウェブサイトを扱うことです。一部のウェブサイトは、セキュリティキャプチャや速度制限などの技術を使用して、スクレイパーがページからデータを抽出できないようにします。これにより、これらのウェブサイトからデータを収集することが難しくなり、プロキシやヘッドレスブラウザなどの高度なウェブスクレイピング技術を使用する必要があるかもしれません。

全体として、ウェブスクレイピングは困難で時間がかかる作業かもしれませんが、データアナリストがさまざまなソースからデータを収集するために持つ必要な重要なスキルであり、データアナリストが持つべき必須の能力です。

6. 大量のデータをウェブスクレイピングする方法

大量のデータをウェブからスクレイピングするには、効率的で拡張可能なスクレイピング作業を実現するために、複数の技術を組み合わせて使用する必要があります。大量のデータをスクレイピングする際に考慮すべきいくつかの主要なポイントは次のとおりです。

分散スクレイピングアーキテクチャの使用: 単一システムで単一のスクレイパーを実行する代わりに、複数のシステムで複数のスクレイパーを並行して実行できる分散アーキテクチャを使用します。これにより、スクレイピング作業を拡張し、データをより迅速に収集することができます。

キャッシングとキューイングの使用: 大量のデータをスクレイピングする際には、キャッシングとキューイングを使用して収集したデータを保存および管理することが有用である場合があります。キャッシングを使用すると、データを一時的に保存できるため、同じデータを複数回スクレイピングする必要がなくなり、キューイングを使用すると、スクレイピングプロセスをより効率的に管理するためにスクレイピングするページとタイミングを優先的に指定できます。

ヘッドレスブラウザの使用: ヘッドレスブラウザは、ユーザーインターフェイスなしで実行されるWebブラウザです。これにより、JavaScriptを実行し、通常のWebブラウザでレンダリングされるようにページを生成できるため、JavaScriptを使用してコンテンツをレンダリングするWebサイトをスクレイピングするのに役立つ場合があります。これにより、JavaScriptベースの複雑な構造を持つWebサイトをより簡単にスクレイピングできます。

プロキシの使用: プロキシを使用すると、複数のIPアドレスを介してウェブスクレイピングトラフィックをルーティングできるため、スクレイピングを防ごうとするウェブサイトで検出およびブロックされることを防ぐことができます。これは厳格なスクレイピングポリシーがあるウェブサイトから大量のデータをスクレイピングするのに役立つ場合があります。

7. ウェブスクレイピング専門企業ハッシュクレイパー(Hashcraper)

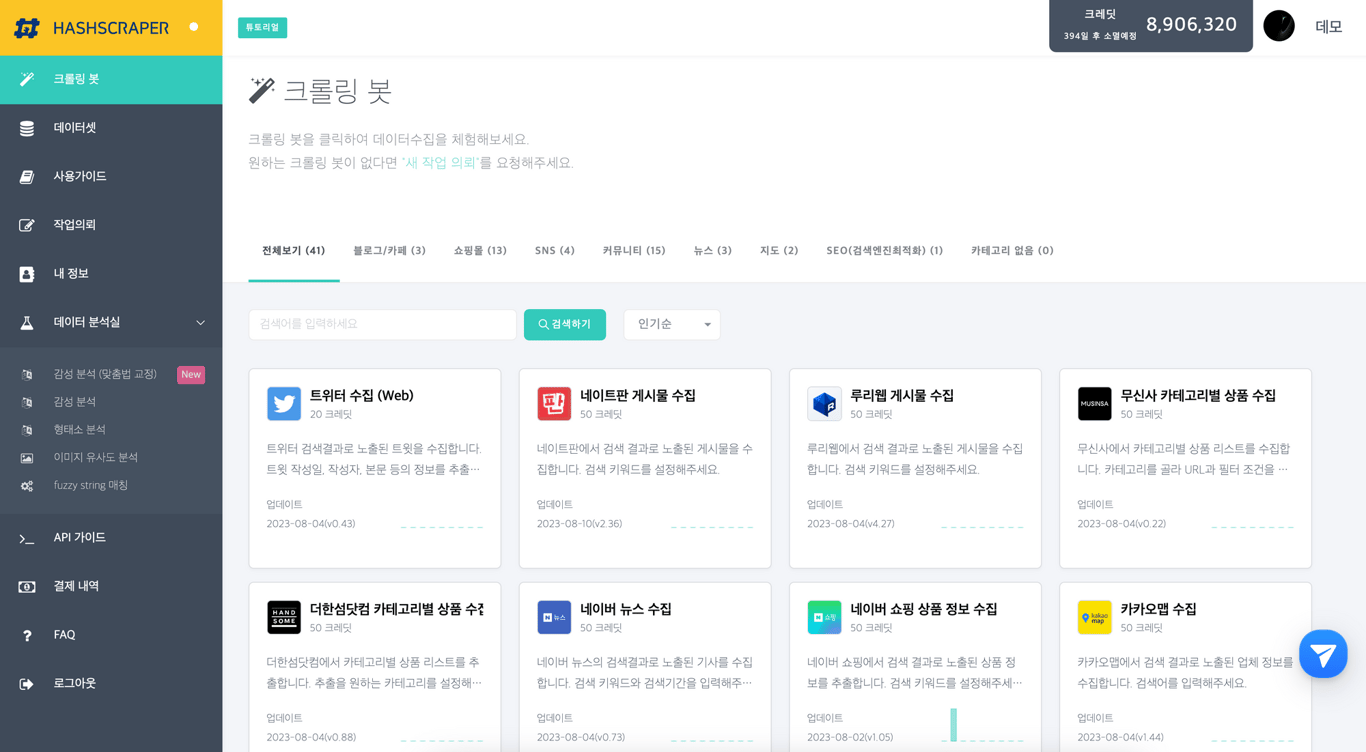

ハッシュクレイパーデータ収集ダッシュボード(SNS、コミュニティ、イコマースなどからデータを収集できます)

ハッシュクレイパーは、ウェブクローリングを専門とする会社であり、インターネットから大量のデータをスクレイピングするために必要なすべての技術を備えています。

ハッシュクレイパーには、ウェブをクローリングし、大規模なデータを収集するために必要な高度なアルゴリズムと洗練されたソフトウェアを使用する熟練したデータアナリストおよび開発者チームがいます。これにより、多くのデータを手動で訪れることなく、多くのデータを迅速かつ効率的に収集することができます。

会社のウェブスクレイピング技術は、最大かつ複雑なデータセットも処理できます。複雑なレイアウトと構造を持つウェブサイトだけでなく、認証が必要なサイトやスクレイピングを防ぐためにCAPTCHAを使用するサイトからもデータを抽出できます。

ハッシュクレイパーは、ウェブクローリング以外にも、企業がデータを理解するのに役立つさまざまなその他のサービスを提供しています。これには、データのクリーニングと前処理、データの可視化と統計分析が含まれます。会社の専門家チームは、組織がデータのトレンドやパターンを識別し、この情報を活用して情報に基づいた決定を下すのに役立ちます。