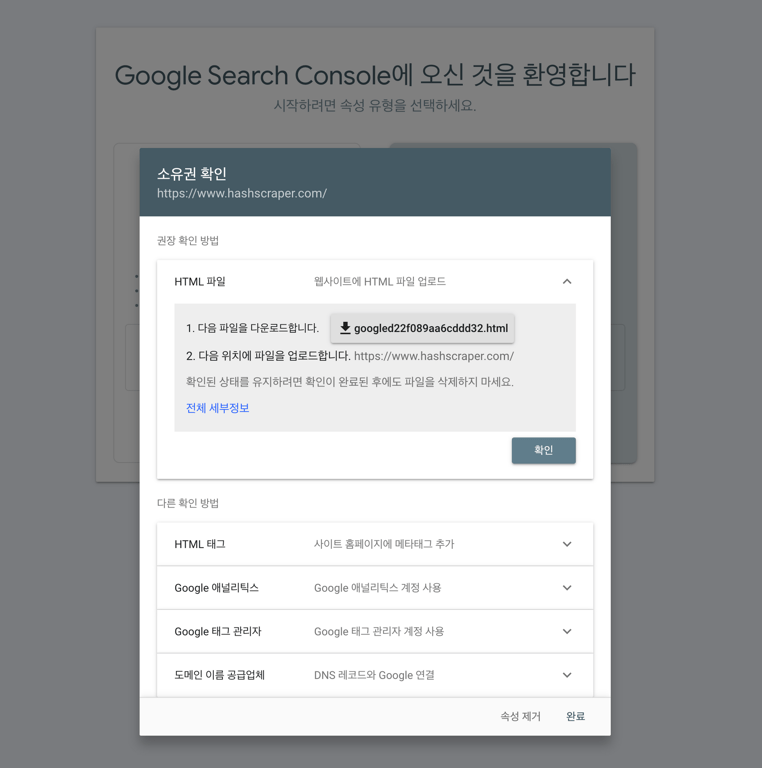

1. Google Suche Konsole für Problembehebung

Nach Überprüfung der Domain wird, sobald der Crawling-Bot mit dem Crawling beginnt, die Daten angezeigt. Bitte überprüfen Sie einige Tage später erneut, um die Daten sehen zu können.

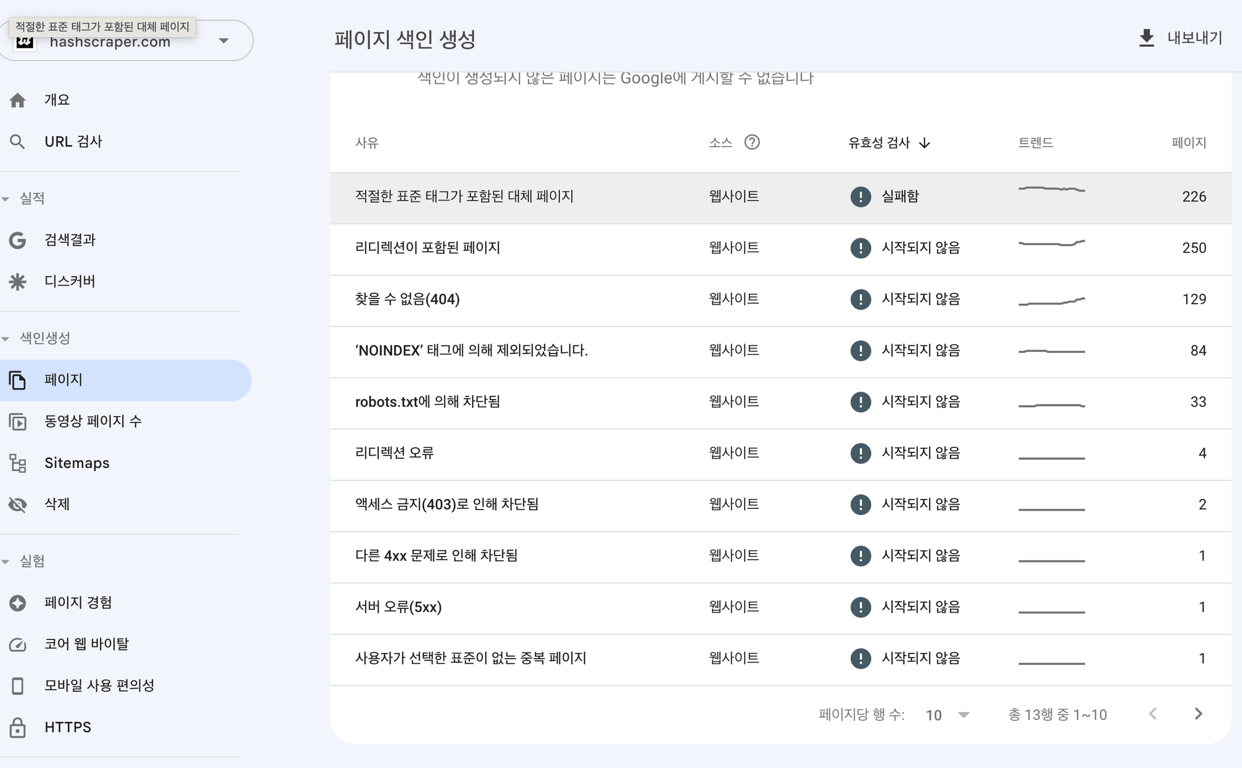

Die häufigsten Fehler beim Crawlen sind:

- Zeitüberschreitung

- Verbindung abgelehnt

- Verbindung fehlgeschlagen

- Verbindungszeitüberschreitung

- Keine Antwort

In den meisten Fällen sind Serverfehler vorübergehend, aber wenn der Fehler anhält, überprüfen Sie bitte, ob es ein Problem mit dem Server gibt, und gelegentlich kann es zu Fehlern des Hosting-Anbieters kommen. Bitte kontaktieren Sie den Hosting-Anbieter.

Wenn die robots.txt-Datei einen 200- oder 404-Fehler zurückgibt, bedeutet dies, dass Suchmaschinen Schwierigkeiten haben, diese Datei zu durchsuchen.

Stellen Sie sicher, dass die robots.txt-Sitemap fehlerfrei ist und eingereicht wird, oder überprüfen Sie auf der Serverseite, ob es Blockaden für Bots gibt.

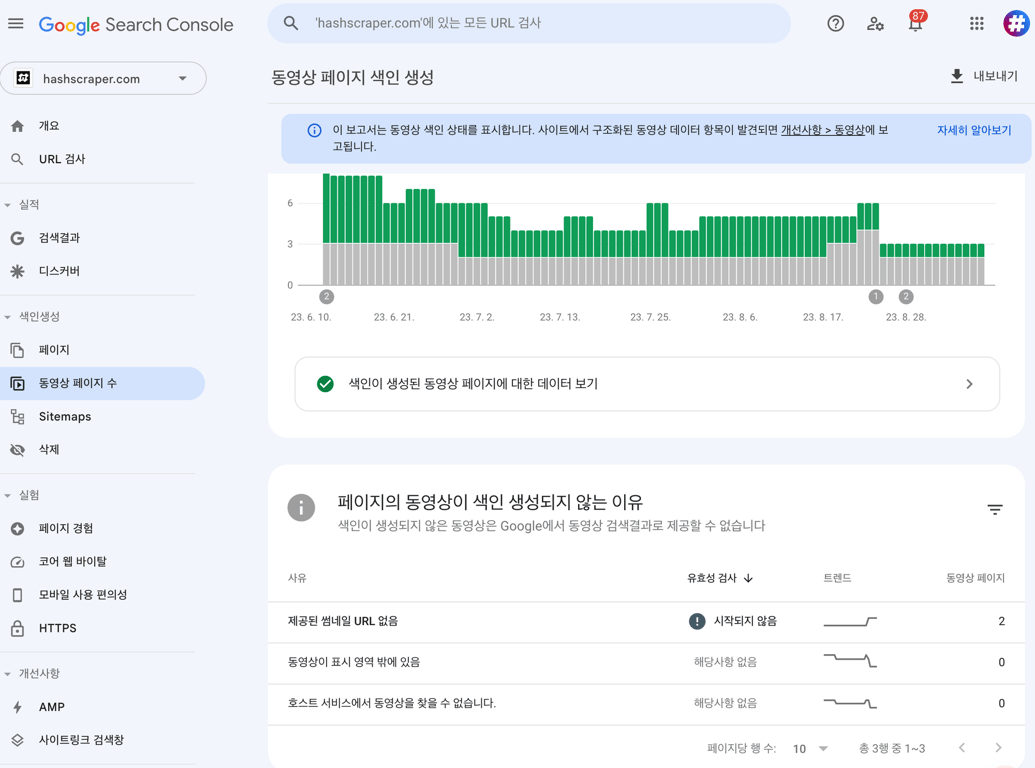

2. Sitemap erstellen

Der Crawler beginnt in der Regel mit dem Crawlen anhand der Sitemap auf der Homepage.

Das Erstellen einer fehlerfreien Sitemap erleichtert dem Bot das Crawlen.

3. Regelmäßige Aktualisierung neuer Inhalte

Durch regelmäßige Erstellung neuer Inhalte wird die Suchmaschine dazu veranlasst, die Website häufiger zu crawlen.

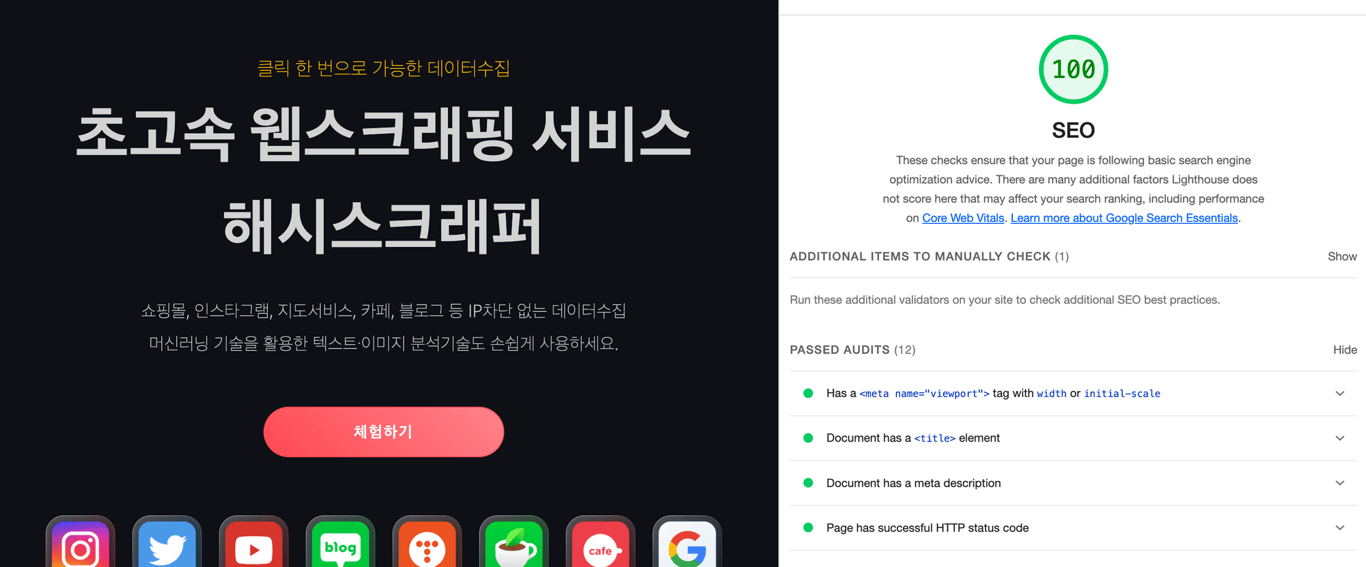

4. Mobile freundliche Website erstellen

Mit der Einführung der mobilen Indexierung ist es wichtig, mobile optimierte Seiten für den mobilen Index zu erstellen.

Wenn die Website nicht mobil optimiert ist, kann dies zu einem Rankingverlust führen.

Hier sind einige wichtige Methoden zur Erstellung einer mobilen freundlichen Website:

a. Implementierung eines responsiven Webdesigns

b. Einbindung von Viewport-Metatags in den Inhalt

c. Minimierung der Ressourcen (CSS und JS) auf der Seite

d. AMP-Cache für Seiten-Tags festlegen

e. Bildoptimierung zur Verkürzung der Ladezeiten

f. Verkleinerung der Größe von UI-Elementen auf der Seite

Testen Sie die Website auf mobilen Plattformen und optimieren Sie sie mithilfe von Google PageSpeed.

Die Seitenladegeschwindigkeit ist ein wichtiger Rankingfaktor und kann die Crawling-Geschwindigkeit der Suchmaschine beeinflussen.

5. Entfernung von doppelten Inhalten

Doppelte Inhaltsseiten werden bestraft.

Durch Optimierung von Canonical-Tags oder Metatags können Sie dies vermeiden.

6. Einschränkung der Sichtbarkeit bestimmter Seiten

Wenn Sie möchten, dass Suchmaschinen bestimmte Seiten nicht crawlen, können Sie dies auf folgende Weise tun:

- Platzierung des 'noindex'-Tags.

- Platzierung der URL in der robots.txt-Datei.

7. Backlinks von externen Websites auf die Homepage setzen

Backlinks sind Links von anderen Websites auf Ihre Website.

Diese Links verbinden Ihre Website mit autoritativen Quellen zu bestimmten Inhalten.

Suchmaschinen bewerten dadurch das Vertrauen und die Autorität Ihrer Website.

Links von vertrauenswürdigen Quellen haben einen größeren Einfluss.

Lesen Sie auch diesen Artikel:

Daten sammeln, jetzt automatisieren

Starten Sie in 5 Minuten ohne Codierung · Erfahrung mit dem Crawlen von über 5.000 Websites