0. ¿Por qué las grandes empresas están contratando analistas de datos en estos días?

Las grandes empresas contratan analistas de datos porque necesitan analizar una gran cantidad de datos para tomar decisiones comerciales basadas en la información.

Los analistas de datos utilizan diversas herramientas y tecnologías para analizar estos datos y proporcionar información que ayude a las empresas a mejorar sus operaciones, aumentar sus ingresos y mantener su competitividad en el mercado.

Con la proliferación de Big Data, la demanda de analistas de datos ha aumentado significativamente en los últimos años y se espera que siga creciendo en el futuro.

1. ¿Qué se necesita estudiar para convertirse en analista de datos?

Para convertirse en analista de datos, es necesario estudiar una combinación de informática, estadística y negocios.

Se requiere una sólida base en lenguajes de programación informática como Python y SQL, así como experiencia en software de análisis estadístico como R o SAS. También es importante tener un buen entendimiento de los principios comerciales y la capacidad de comunicarse efectivamente con partes interesadas no técnicas.

Además, es fundamental perfeccionar constantemente las habilidades en aprendizaje automático y visualización de datos para aumentar la competitividad en el mercado laboral.

2. ¿Qué tipos de datos suelen analizar los analistas de datos en las empresas?

Los analistas de datos suelen utilizar datos internos de la empresa y datos web para apoyar a la organización en la toma de decisiones basadas en la información.

Esto puede incluir la recopilación, organización y estructuración de grandes conjuntos de datos, así como la identificación de tendencias y patrones mediante métodos estadísticos y de análisis.

Los analistas de datos también pueden utilizar herramientas como hojas de cálculo y bases de datos para almacenar y manipular datos, así como crear informes y visualizaciones para comunicar los resultados a otros dentro de la organización.

El objetivo de un analista de datos es utilizar los datos para ayudar a la organización a mejorar sus operaciones y alcanzar sus objetivos.

3. ¿Qué habilidades se deben aprender para recolectar datos externos como analista de datos?

Como analista de datos, se deben aprender diversas habilidades para recolectar datos externos. Las habilidades clave a aprender incluyen web scraping, integración de API y SQL.

El web scraping implica extraer datos de sitios web utilizando software especializado. Esto puede ser útil para recolectar datos de sitios web que no proporcionan otro medio de acceso a través de API u otros métodos directos.

La integración de API implica el uso de interfaces de programación de aplicaciones (API) para acceder a los datos de sitios web u otros servicios en línea. Muchos sitios web y servicios proporcionan API para que los desarrolladores accedan a los datos de manera sistemática y programática.

SQL (Structured Query Language) es un lenguaje de programación utilizado para administrar y manipular datos almacenados en bases de datos. Es importante tener habilidades en SQL para acceder y analizar datos almacenados en bases de datos como analista de datos.

Además de estas habilidades técnicas, también se requiere una sólida capacidad de resolución de problemas y comunicación para recolectar y analizar datos externos de manera efectiva.

4. ¿Cuál es el salario de un analista de datos con habilidades sobresalientes en recolección de datos?

El salario exacto de un analista de datos con habilidades sobresalientes en recolección de datos puede variar según factores como el puesto específico, la industria, la ubicación, el nivel de experiencia, las habilidades técnicas específicas, entre otros, por lo que es difícil determinar un salario exacto.

Según datos de la Oficina de Estadísticas Laborales, el salario promedio en el campo de análisis de datos, incluidos los analistas de datos, fue de $84,810 en mayo de 2019. Sin embargo, este número puede no reflejar los salarios de los mejores analistas de datos. Por lo general, los analistas de datos con habilidades sobresalientes en recolección de datos y un sólido historial en el campo pueden recibir salarios más altos que aquellos con habilidades y experiencia más generales.

Se puede observar que los analistas de datos o científicos de datos tienden a recibir salarios relativamente altos en campos relacionados.

5. ¿Cuál es la parte más difícil del web scraping?

Como analista de datos, es fundamental tener habilidades para recolectar datos.

Una de las partes más difíciles del web scraping es lidiar con la estructura cambiante de las páginas web. Los sitios web a menudo se actualizan y redesdiseñan, lo que puede provocar cambios en la estructura de las páginas. Dado que los scripts de web scraping están diseñados para extraer datos de elementos específicos de la página web según su estructura, estos cambios pueden afectar el funcionamiento de los scripts de web scraping. Por lo tanto, es necesario actualizar y mantener los scripts de web scraping con frecuencia para que sigan funcionando correctamente.

Otro desafío del web scraping es tratar con sitios web que intentan evitar el scraping. Algunos sitios web utilizan tecnologías como captchas y limitaciones de velocidad para evitar que los scrapers extraigan datos de sus páginas. Esto puede dificultar la recolección de datos en estos sitios y puede requerir el uso de tecnologías avanzadas de web scraping como proxies y navegadores headless.

En general, el web scraping puede ser un trabajo difícil y que consume mucho tiempo, pero es una habilidad importante que los analistas de datos deben tener para recolectar datos de diversas fuentes y es una habilidad esencial que deben poseer.

6. Cómo hacer scraping de grandes cantidades de datos en la web

Para hacer scraping de grandes cantidades de datos en la web de manera eficiente y escalable, es necesario combinar varias tecnologías. Algunos aspectos clave a considerar al hacer scraping de grandes cantidades de datos son los siguientes:

Uso de arquitectura de scraping distribuido: En lugar de ejecutar un scraper único en un solo sistema, se puede utilizar una arquitectura distribuida que permita ejecutar múltiples scrapers en paralelo desde varios sistemas. Esto permite escalar los esfuerzos de scraping y recolectar datos de manera más rápida.

Uso de caching y colas: Al hacer scraping de grandes cantidades de datos, puede ser útil utilizar caching y colas para almacenar y gestionar los datos recolectados. El caching permite almacenar temporalmente los datos para evitar tener que volver a hacer scraping de los mismos datos repetidamente, mientras que las colas permiten priorizar las páginas a ser scrapeadas y gestionar de manera más eficiente el proceso de scraping.

Uso de navegadores headless: Un navegador headless es un navegador web que se ejecuta sin interfaz de usuario. Esto permite que el navegador headless ejecute JavaScript y genere páginas como lo haría un navegador web normal, lo que puede ser útil para hacer scraping de sitios web que utilizan estructuras complejas basadas en JavaScript. Esto facilita el scraping de sitios web que utilizan estructuras basadas en JavaScript.

Uso de proxies: El uso de proxies permite enrutar el tráfico de scraping a través de múltiples direcciones IP, lo que puede ayudar a evitar la detección y bloqueo de scraping por parte de los sitios web que intentan evitarlo. Esto puede ser útil al hacer scraping de grandes cantidades de datos en sitios web con políticas estrictas de scraping.

7. Hashcraper, una empresa especializada en web scraping

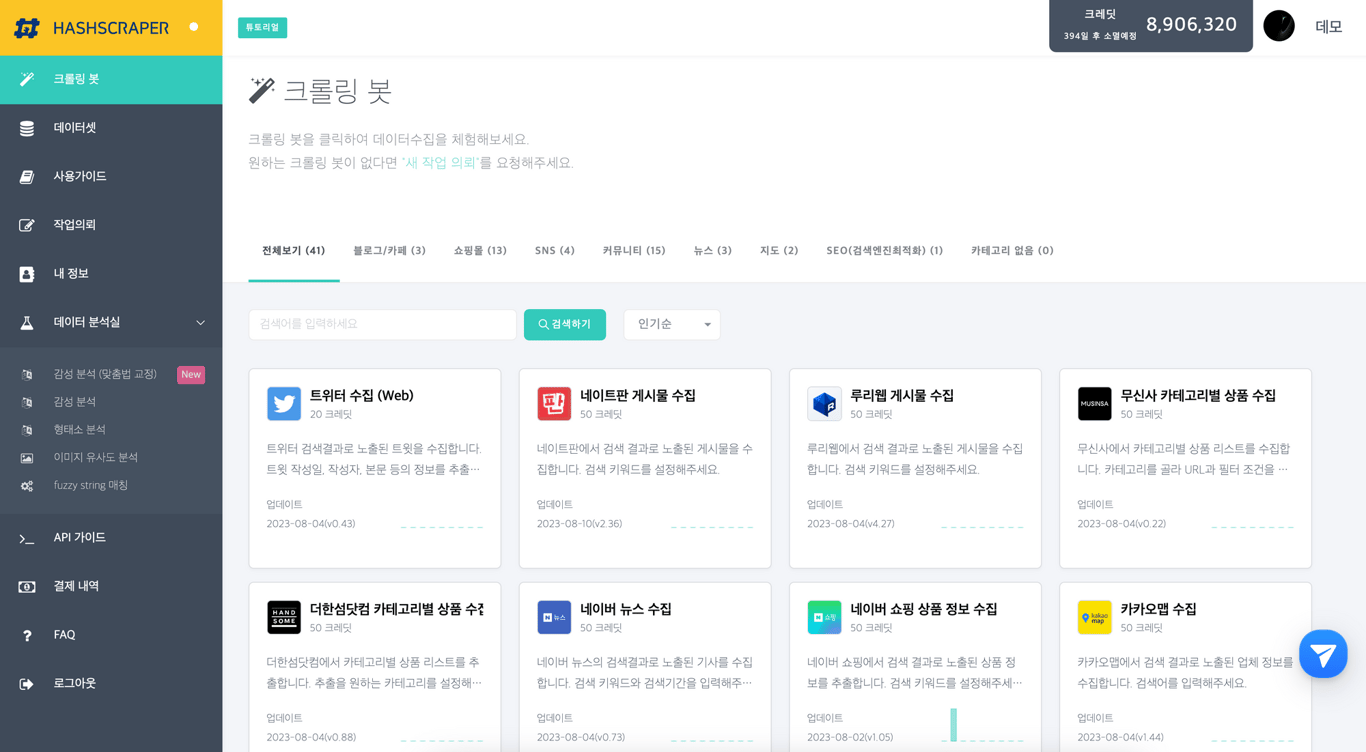

Tablero de recolección de datos de Hashcraper (puede recolectar datos de redes sociales, comunidades, comercio electrónico, etc.)

Hashcraper es una empresa especializada en web scraping que posee todas las tecnologías necesarias para hacer scraping de grandes cantidades de datos en Internet.

Hashcraper cuenta con un equipo de expertos en web scraping, analistas de datos y desarrolladores altamente capacitados. Utilizan algoritmos avanzados y software sofisticado para hacer scraping de la web y recolectar datos a gran escala. Esto les permite recolectar una gran cantidad de datos de manera rápida y eficiente sin tener que visitar manualmente cada sitio web.

La tecnología de web scraping de la empresa puede manejar incluso los conjuntos de datos más grandes y complejos. Pueden extraer datos de sitios web con diseños y estructuras complejas, así como de sitios que requieren autenticación o utilizan captchas para evitar el scraping.

Además del web scraping, Hashcraper ofrece una variedad de otros servicios que ayudan a las empresas a comprender sus datos. Esto incluye limpieza y preprocesamiento de datos, visualización de datos y análisis estadístico. El equipo de expertos de la empresa puede ayudar a las organizaciones a identificar tendencias y patrones en los datos y utilizar esta información para tomar decisiones basadas en la información.

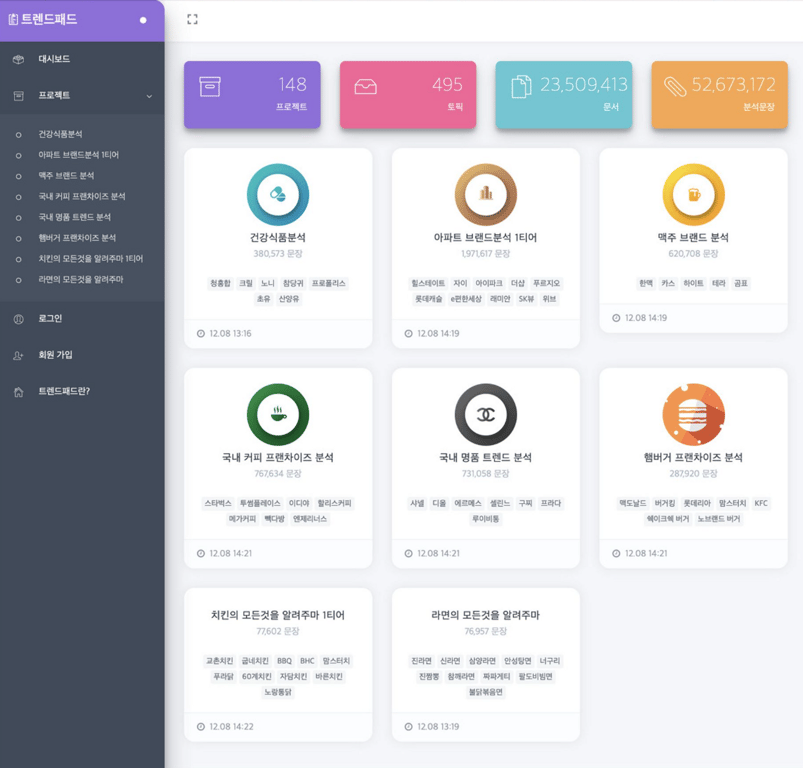

Servicio de análisis de tendencias en tiempo real - TrendPad

También te puede interesar leer:

Automatiza la recolección de datos ahora

Comienza en 5 minutos sin necesidad de codificación · Experiencia en scraping de más de 5,000 sitios web