Si estás cansado de recortar noticias, ¡asegúrate de leer esto! ¡Perderás tiempo si no conoces este método!

¿Estás buscando palabras clave en los numerosos artículos de noticias, leyendo los artículos, copiando y pegando repetidamente? ¡Puedes automatizar la recopilación de noticias a través del web scraping para ahorrar tiempo y dinero!

Muchas personas revisan las noticias de la industria en los sitios web de noticias todos los días para mantenerse al tanto de las últimas tendencias. Buscar noticias relacionadas con nuestra empresa todos los días es una rutina importante para comprender las tendencias industriales, las perspectivas del mercado, observar las acciones de los competidores y rastrear los cambios en las políticas y regulaciones gubernamentales para mejorar la competitividad.

Sin embargo, buscar manualmente nuevos artículos que se vierten a diario es muy tedioso e ineficiente. Esta es una tarea repetitiva típica que aumenta la fatiga de los trabajadores, y a medida que aumenta el número de palabras clave a buscar, el tiempo y los costos laborales aumentan significativamente.

¡Ahora prueba automatizar la tarea de recopilación de noticias utilizando el web scraping! Con un servicio automatizado, puedes recopilar noticias relevantes cada mañana.

Aquí se presenta el caso de la empresa A, una empresa de fintech que ha automatizado al 100% el trabajo de recorte de noticias con Hashscraper.

1. Antes y Después

Problema: El aumento constante de los costos laborales en la tarea de recorte de noticias y la dificultad de desarrollar y mantener un web crawler por sí mismo...

La empresa A quería recopilar noticias relevantes diariamente en toda la industria de fintech, incluidos sectores como finanzas, blockchain, pagos simplificados, P2P, gestión de activos, para observar las tendencias del mercado y de los competidores y proporcionar noticias seleccionadas a los miembros de la empresa. La parte más ineficiente era la recopilación de artículos de noticias.

Extraer y gestionar manualmente los artículos de noticias era una tarea repetitiva muy tediosa, y a medida que aumentaban las búsquedas de tendencias de la industria, noticias de competidores y noticias relacionadas con la empresa, la preocupación por la eficiencia crecía. Incluso al desarrollar un web crawler interno, surgían problemas de bloqueo de IP y mantenimiento del web crawler con frecuencia.

Finalmente, la empresa A recurrió a Hashscraper para mejorar esta ineficiencia.

Solución: Proceso completamente automatizado desde la recopilación diaria de noticias hasta el envío por correo, sin intervención manual

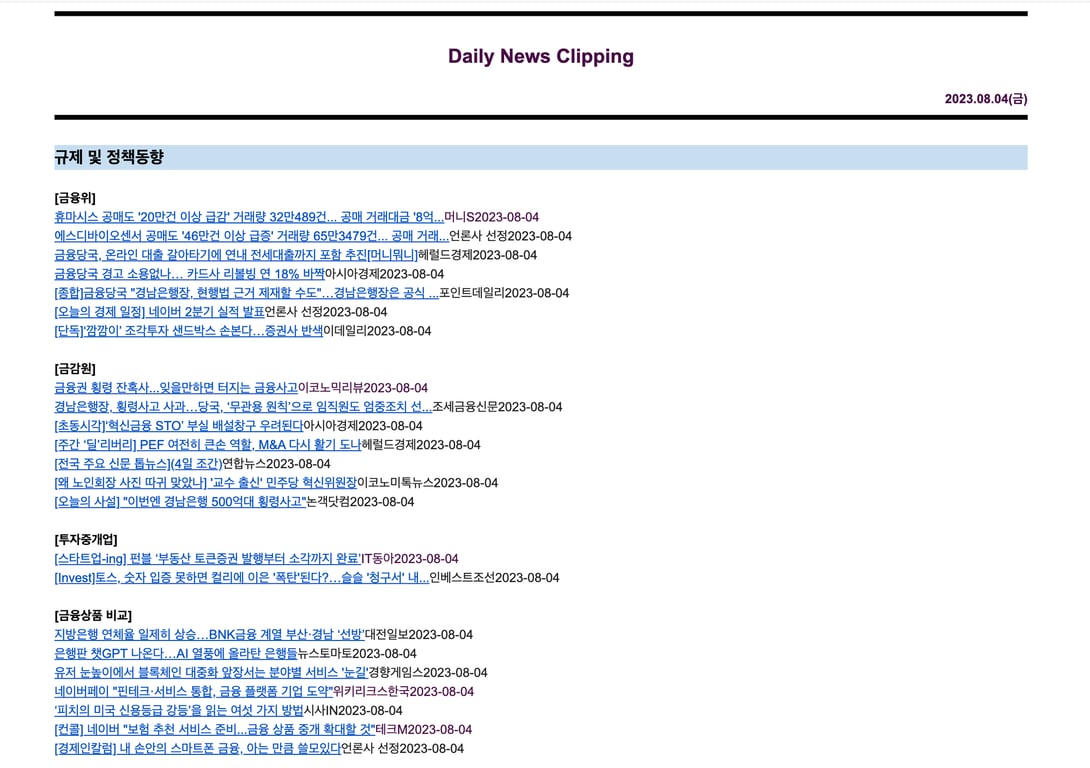

Simplemente configura las palabras clave que deseas buscar, y el bot de web scraping de Hashscraper recopilará los artículos relevantes y los enviará por correo electrónico todos los días, por lo que no tienes que preocuparte por nada más.

Especialmente, la amplitud de la búsqueda de sitios web y palabras clave ha aumentado significativamente. Anteriormente, al realizarlo manualmente, solíamos buscar alrededor de 10 palabras clave en 1-2 sitios web, pero desde la implementación de Hashscraper, ahora buscamos alrededor de 100 palabras clave en 3 sitios web principales para recortar noticias diariamente.

Además, los bots de web scraping de Hashscraper se gestionan a través de un sistema de monitoreo de recopilación en tiempo real y proporcionan mantenimiento inmediato en caso de errores, lo que permite enviar rápidamente noticias seleccionadas a los miembros sin preocupaciones de gestión.

Imagen: Captura de pantalla del correo de recorte diario de noticias

2. Ejemplos de uso de los bots de recopilación de noticias de Hashscraper

Función recomendada: Recopilación automática diaria y envío automático por correo

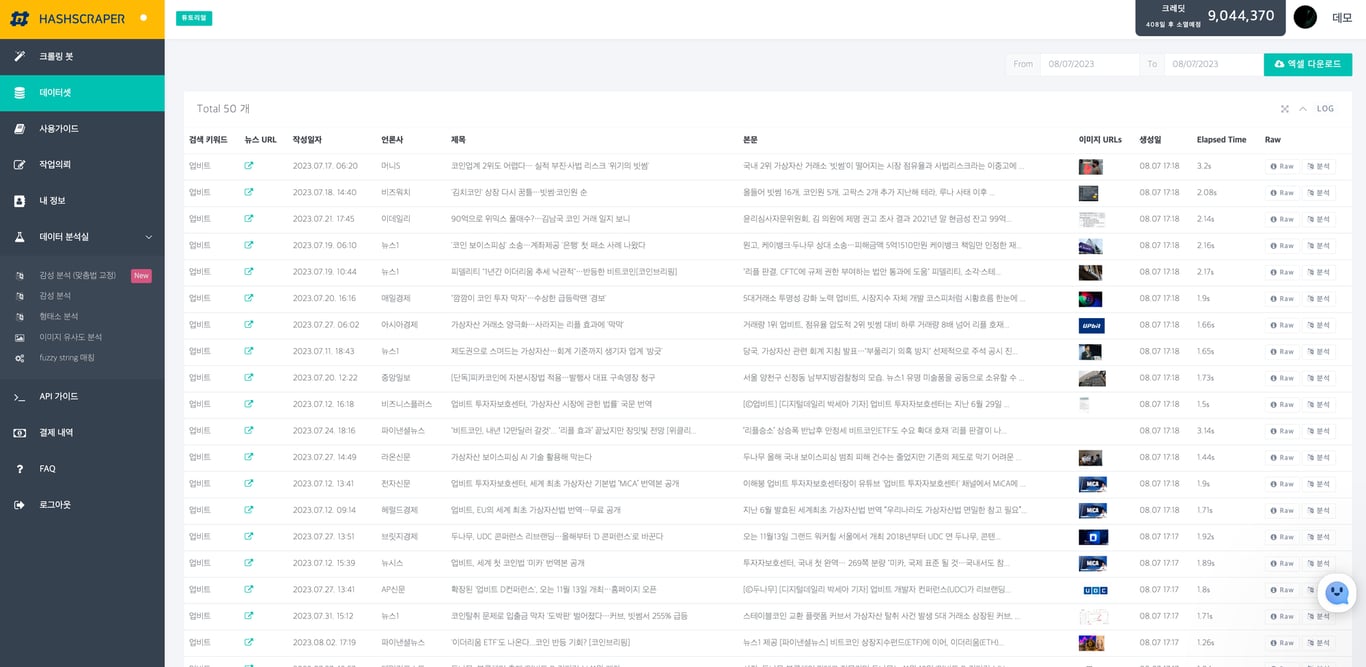

Hashscraper ofrece la recopilación de noticias de varios portales como Google, Naver, Daum, entre otros. Simplemente configura las palabras clave que deseas buscar y extraerá los resultados de la búsqueda. Al integrar el servicio de envío automático por correo, puedes recibir un informe por correo electrónico con las noticias recopiladas en el momento deseado para compartirlas fácilmente con los miembros. ¡El responsable no tiene que preocuparse por nada en este proceso! :)

Si tienes un equipo de desarrollo interno, además de la integración automática por correo electrónico, también puedes descargar datos en Excel y recibirlos fácilmente a través de API.

Imagen: Tabla de resultados de recopilación de noticias de Naver adjunta

¿Estás preocupado por la tarea ineficiente de recorte de noticias que es esencial pero tediosa para nuestra empresa? ¿No es una carga pesada para tu equipo de desarrollo interno desarrollar un web crawler por sí mismos?

Si deseas automatizar por completo tareas repetitivas como el recorte diario de noticias, prueba implementar Hashscraper como lo hizo la empresa A. Si dejas una consulta de implementación a continuación, Hashscraper, con una amplia experiencia en recopilación y análisis de datos web, puede ofrecerte la mejor solución para resolver tus preocupaciones.

También te recomendamos leer este artículo:

Automatiza la recopilación de datos ahora

Comienza en 5 minutos sin necesidad de programación · Experiencia en rastreo de más de 5,000 sitios web